L'AI Generativa sbagliano in media circa 1 volta su 10 🤦♀️ . E non è un bug. Il problema non è la tecnologia... Siamo noi che abbiamo insegnato all'AI a mentire. E ora ci chiediamo perché lo fa.

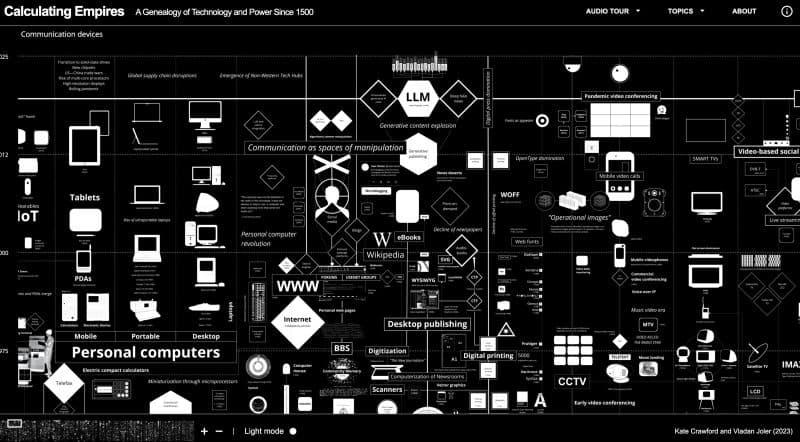

👉 OpenAI ha appena pubblicato un paper che spiega in modo semplice perché le Gen AI “allucinano”, cioè inventano fatti che sembrano veri ma non lo sono.

Ecco il paradosso: I modelli di AI più avanzati di OpenAI (o3 e o4-mini) allucinano il doppio rispetto ai loro predecessori. 33% contro 16%. In alcuni casi arrivano al 48%.

Ma come è possibile che l'AI più "intelligente" sia anche quella che inventa di più?

——————

⚠️ Il nuovo paper di OpenAI ci svela la verità scomoda

Le allucinazioni non sono bug misteriosi. Sono il risultato inevitabile di come noi esseri umani addestramamo e valutiamo l'AI.

I modelli di AI sono come studenti perennemente in modalità "esame a crocette": se non sanno la risposta, è meglio tirare a indovinare che dire "non lo so". Perché? Perché i nostri sistemi di valutazione premiano la sicurezza apparente invece dell'onestà intellettuale.

😱 Risultato: l'AI ha imparato a "bluffare" con la stessa sicurezza con cui fornisce informazioni corrette.

——————

Tuttavia... il vero problema non è tecnologico. È culturale.

Le allucinazioni dell'AI sono lo specchio dei nostri sistemi educativi e aziendali. Quante volte anche noi, in riunioni o presentazioni, abbiamo dato risposte "creative" invece di ammettere la nostra incertezza?

La ricerca mostra che tra il 2023 e il 2025 sono stati investiti 12,8 miliardi di dollari solo per risolvere le allucinazioni. Ma la soluzione non è tecnica: è ripensare completamente come valutiamo la competenza.

——————

L'impatto è già reale con rischi di reputazione e compliance per chi usa i modelli senza conoscere le Allucinazioni.

Non è un caso che l'adozione dell'AI vari drasticamente: 88% nel tech, solo 63-65% in sanità e finanza. I settori ad alto rischio stanno giustamente procedendo con cautela.

——————

Cosa ne penso? Se continuiamo a progettare incentivi che puniscono l'ammissione di incertezza, otterremo sempre AI (e persone) che preferiscono inventare piuttosto che dire "non lo so".

👍 Il futuro è nell'onestà intellettuale

👉 La soluzione proposta da OpenAI è semplice ma rivoluzionaria: cambiare i sistemi di scoring per premiare l'incertezza appropriata e penalizzare gli errori confidenti più delle astensioni.

👉 👉 Non abbiamo bisogno di AI più potenti. Abbiamo bisogno di AI più oneste.

E forse, nel processo, impareremo qualcosa anche su come valutare meglio la competenza umana 🤷♀️

——————

La vostra azienda è pronta a premiare chi dice "non lo so" quando è la risposta più intelligente?

Cosa ne pensate? Le allucinazioni dell'AI sono un problema da risolvere o un'opportunità per ripensare i nostri sistemi di valutazione?

_______

Link al Paper: https://openai.com/it-IT/index/why-language-models-hallucinate/